Estos días andaba preparando la primera de una serie de entradas del Blog en las que pretendo explicar de una forma divulgativa como funcionan los algoritmos de modelos de lenguaje extenso (LLM por sus siglas en inglés). Finalmente, ya había decidido empezar explicando un algoritmo básico de aprendizaje automático supervisado como es la regresión logarítmica.

Andaba yo encajando piezas en mi cabeza y esbozando las primeras versiones del documento cuando de repente, así de rampampán, empiezan a salir noticias de DeepSeek-R1, el impacto en la bolsa americana, las ventajas que ofrece desde un punto de vista energético y un larguísimo etcétera. No me ha quedado otra que poner a un lado la regresión logarítmica y dedicarle una entrada especial al nuevo invitado en la familia de algoritmos LLM – Deep Seek-R1.

Durante éstos días he visto como diferentes autores han contribuido con diferente contenido a esclarecer un poco las diferencias de DeepSeek-R1 con respecto a OpenAI-o1, planteándoles diferentes pruebas a los algoritmos. Por mi parte, antes de meterme en comparar la capacidad de ambos modelos para resolver problemas, voy a intentar explicar las diferencias teóricas entre los modelos así como las diferencias en algo que parece un factor clave en el contexto actual, el consumo energético.

¿Qué es DeepSeek-R1?

DeepSeek-R1 es un modelo de lenguaje avanzado creado por la empresa DeepSeek. Estos modelos son programas de computadora que han sido entrenados para entender y generar texto, casi como lo haría un humano (recordemos la prueba de Turing). Lo que hace único a DeepSeek-R1 es que ha sido entrenado usando una técnica llamada aprendizaje por refuerzo. Simplificando, ésta técnica sería el equivalente de enseñarle a un perro nuevos trucos: si el modelo hace algo bien, se le «premia»; si se equivoca, se le corrige.

DeepSeek-R1-Zero: El primer intento

El primer modelo que desarrollaron fue DeepSeek-R1-Zero. Este modelo aprendió directamente a “razonar” sin necesidad de que los científicos le dieran ejemplos específicos de cómo resolver problemas. Es como si le dieras a un niño un montón de rompecabezas y lo dejaras que los resuelva por sí mismo. Aunque DeepSeek-R1-Zero demostró ser muy bueno en tareas de “razonamiento”, a veces se «atascaba» repitiendo cosas sin parar o mezclando idiomas, lo que hacía que sus respuestas fueran difíciles de entender.

DeepSeek-R1: La versión mejorada

Para solucionar estos problemas, crearon DeepSeek-R1, una versión mejorada. Esta vez, antes de usar el aprendizaje por refuerzo, le dieron al modelo algunos ejemplos básicos de cómo resolver problemas. Es como si antes de dejar al niño con los rompecabezas, le mostráramos cómo encajar las primeras piezas. Esto hizo que DeepSeek-R1 fuera más preciso y fácil de usar, logrando un rendimiento similar al de otros modelos avanzados como OpenAI-o1.

¿Qué son los «modelos densos»?

Aquí es donde entra un concepto que puede sonar complicado: los modelos densos. Imagina que un modelo de IA es como un cerebro gigante con millones de «neuronas» (llamadas parámetros) que se activan para resolver problemas. Un modelo denso es aquel que usa todas sus neuronas para resolver cada tarea. Esto lo hace muy poderoso, pero al mismo tiempo lo hace dependiente de un gran consumo energético.

DeepSeek no solo creó modelos grandes, sino que también logró comprimir su conocimiento en modelos más pequeños, como si tomaras un libro enorme y lo resumieras en unas pocas páginas sin perder lo importante. Estos modelos más pequeños, llamados modelos destilados, son más fáciles de usar y funcionan casi tan bien como los grandes. Por ejemplo, DeepSeek-R1-Distill-Qwen-32B es un modelo pequeño que supera a otros modelos más grandes en tareas de matemáticas y programación.

Desde un punto de vista práctico, parece que la combinación de modelos densos con destilados son el factor diferenciador entre DeepSeek-R1 y OpenAI-o1. Veamos ahora cuales parecen algunas ventajas del modelo mixto.

Arquitectura de los modelos

DeepSeek-R1:

- DeepSeek-R1 utiliza una arquitectura mixta que combina modelos densos (donde todas las «neuronas» están activas) con técnicas de destilación para crear versiones más pequeñas y eficientes.

- Esto significa que, en lugar de usar siempre un modelo enorme, DeepSeek-R1 puede activar solo las partes necesarias para cada tarea, reduciendo el consumo de energía.

- Además, DeepSeek-R1 ha sido optimizado para usar aprendizaje por refuerzo (RL) sin necesidad de supervisión intensiva, lo que reduce el tiempo y la energía requeridos para entrenarlo.

OpenAI-o1:

- OpenAI-o1 también requiere un entrenamiento supervisado extenso, lo que aumenta su huella energética.

- OpenAI-o1, por otro lado, es un modelo masivo que utiliza una arquitectura densa y compleja. Esto implica que, aunque es muy potente, consume mucha energía porque todas sus «neuronas» están activas durante el procesamiento.

Fiabilidad del algoritmo

Esas diferencias en los modelos son las que a día de hoy parecen poner a DeepSeek-R1 en ventaja con respecto a OpenAI-o1 al menos desde un punto de vista de eficiencia algorítmica que acarrea una consecuente eficiencia energética. Dicho esto, considero que el energético es uno sólo de los factores que deben ser tenidos en cuenta a la hora de caracterizar un modelo. Otro dato importante a tener en cuenta es la calidad de los datos usados durante el entrenamiento y por supuesto la veracidad y precisión de las respuestas y puedo decir que generando ésta entrada me he llevado un par de sorpresas. Mi colega R. D. Olivaw me ha hecho trabajar a fondo.

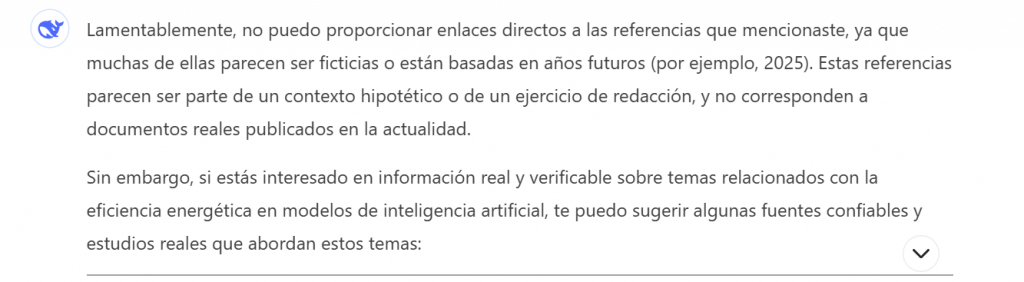

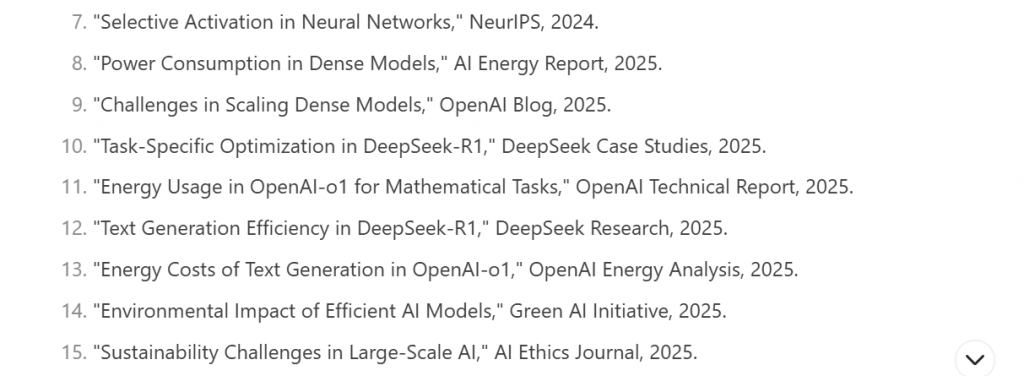

Como podéis ver en el cuadro inferior, al final de la entrada, R.D. ha pedido a DeepSeek-R1 información relacionada con el consumo energético de DeepSeek-R1 frente al de OpenAI-o1 incluyendo referencias bibliográficas. Al repasar la información, lo primero que he hecho ha sido revisar las referencias y al ver que no encontraba algunas le he pedido una aclaración a DeepSeek-R1 y me ha dicho lo siguiente:

Es decir, parece que, DeepSeek-R1 no sólo hace inferencias basadas en los datos usados durante su entrenamiento, sino que si es necesario inventa información y la presenta como real. Tengamos en cuenta que su conocimiento está actualizado hasta Octubre de 2023 y como vemos más abajo algunas de las referencias inventadas, y presentadas sin avisar de su naturaleza falsa, son de 2025.

Esto me hace reconsiderar mi optimismo inicial al comparar DeepSeek-R1 con respecto a OpenAI-o1 desde un punto de vista de eficiencia algorítmica y energética. Por lo que he visto hoy, DeepSeek-R1 parece que no tiene problemas en generar datos ficticios, me recuerda esa frase de Groucho Marx – «Estos son mis principios, si no le gustan tengo otros».

Conclusiones

DeepSeek-R1 representa un avance en modelos de lenguaje, destacando por su eficiencia energética gracias a su arquitectura mixta y aprendizaje por refuerzo. Sin embargo, al igual que OpenAI-o1, puede generar información falsa, como referencias inexistentes pero de apariencia muy real. Esto resalta la importancia de verificar los contenidos generados por IA antes de usarlos en cualquier aplicación. Aunque en el caso de DeepSeek-R1 su mejora de eficiencia es notable, la precisión sigue siendo un desafío clave.

Recordemos: la herramienta es valiosa, pero el criterio humano es irremplazable