Durante los últimos años, la IA Generativa ha transformado la creación de contenido gracias a su capacidad para producir texto, imágenes y código bajo demanda. Herramientas como ChatGPT y Midjourney han demostrado la eficacia con la que los modelos de gran escala pueden generar resultados cuando se formulan instrucciones precisas. Sin embargo, a pesar de sus resultados impresionantes, estos sistemas siguen siendo fundamentalmente reactivos: cada salida depende por completo de una entrada externa y carecen de mecanismos internos para planificar, verificar o adaptar sus resultados más allá de ese alcance.

Agentic AI (Agentes de IA, por sus siglas en inglés) representa la siguiente etapa en esta evolución tecnológica. En lugar de producir respuestas aisladas, los agentes de IA están diseñados para ejecutar flujos de trabajo estructurados que incluyen planificación, verificación y adaptación. Este enfoque transforma la generación estática en un marco basado en procesos, donde cada operación sigue una lógica y puntos de decisión previamente definidos.

En esta entrada exploramos el potencial práctico de Agentic AI mediante un ejemplo concreto: el desarrollo de un agente que revisa de forma automatizada noticias recientes, identifica las más relevantes sobre inteligencia artificial y genera una publicación verificada lista para su difusión en LinkedIn. El código del proyecto está disponible en GitHub.

Este proyecto constituye una demostración práctica de cómo frameworks como LangGraph permiten orquestar flujos de trabajo de múltiples etapas que integran memoria, verificación y lógica de decisión —elementos fundamentales que diferencian a la IA Agéntica de los sistemas generativos tradicionales.

El problema: ¿Por qué la IA Generativa se queda corta?

La IA Generativa ha sido transformadora, pero aún presenta limitaciones estructurales que restringen su autonomía operativa.

- Sin verificación interna: un modelo generativo puede producir texto fluido y convincente, pero carece de mecanismos internos para evaluar la precisión de los hechos o contrastar afirmaciones con las fuentes originales. Como se ha comentado en entradas anteriores, esto puede dar lugar a información incorrecta o engañosa, un fenómeno conocido en el campo de la IA como alucinación.

- Sin memoria: cada interacción se procesa de forma aislada. El contexto no se conserva entre intercambios y debe ser reintroducido por el usuario o la aplicación en cada paso.

- Sin lógica de decisión: los sistemas generativos no gestionan razonamientos de varios pasos, ni priorizan tareas o secuencias adaptativas dentro de un mismo flujo de trabajo.

- Sin orquestación: no pueden coordinar de forma autónoma múltiples herramientas, API o fuentes de datos para completar operaciones complejas.

Como resultado, incluso los modelos de lenguaje más avanzados funcionan como sistemas muy capaces pero limitados en contexto: pueden generar salidas coherentes, aunque no son capaces de ejecutar un proceso completo de principio a fin. Sin memoria persistente, objetivos explícitos o mecanismos de verificación, la IA Generativa sigue siendo un motor de generación estático: potente en expresión, pero limitado en profundidad procedimental.

¿Qué hace que una IA sea “Agentic”?

Agentic AI aborda estas limitaciones mediante la introducción de una proceso estructurado, entendido como la capacidad de ejecutar objetivos predefinidos mediante procesos coordinados y controlados por retroalimentación. De ésta manera, en lugar de generar respuestas aisladas, un agente de IA opera dentro de un ciclo orientado a objetivos que incluye observación, planificación, ejecución, verificación y adaptación. Cada una de estas etapas sigue una lógica explícita establecida por el desarrollador. Este comportamiento no surge de manera espontánea; es el resultado de un diseño deliberado, configuraciones específicas y ajustes finos que garantizan que el flujo de trabajo cumpla su función con consistencia y fiabilidad.

Esta transformación se apoya en varias capacidades clave:

- Lógica de decisión autónoma: el sistema ejecuta reglas o ramas condicionales predefinidas que determinan las operaciones siguientes en función de los resultados intermedios.

- Evaluación de resultados: se implementan procesos para valorar los resultados generados según criterios o mecanismos de verificación establecidos.

- Optimización basada en retroalimentación: mecanismos iterativos ajustan parámetros o estrategias de acuerdo con métricas de rendimiento o señales de error.

- Ejecución orientada a objetivos: el flujo de trabajo se mantiene mediante objetivos definidos a nivel de tarea que guían la secuenciación, priorización y adaptación a las variables contextuales.

- Orquestación de herramientas: uso coordinado de API externas, fuentes de datos y módulos computacionales para completar operaciones en varias etapas.

- Gestión de estado y memoria: persistencia estructurada de datos que conserva información contextual entre pasos, permitiendo continuidad y manejo acumulativo del contexto.

En conjunto, estas propiedades definen Agentic AI como un marco computacional estructurado: un ecosistema interconectado de procesos capaz de coordinar flujos de trabajo complejos, incorporar retroalimentación para la optimización iterativa e integrarse eficazmente en entornos de toma de decisiones humanas.

Proyecto de demostración: LinkedIn News Agent

Para materializar estas ideas, R. Daneel Olivaw y yo desarrollamos un prototipo denominado LinkedIn News Agent, construido sobre el framework LangGraph. Este proyecto muestra cómo Agentic AI trasciende la simple generación de texto al coordinar un flujo de trabajo completo —desde la búsqueda de información hasta la publicación— dentro de un proceso automatizado y verificable. Código del proyecto disponible en GitHub.

El proyecto funciona como un equipo editorial a escala reducida compuesto exclusivamente por módulos de IA, cada uno con una función específica pero integrados en un mismo flujo: producir publicaciones para LinkedIn que sean profesionales, verificadas y atractivas, centradas en las noticias más recientes del ámbito de la inteligencia artificial.

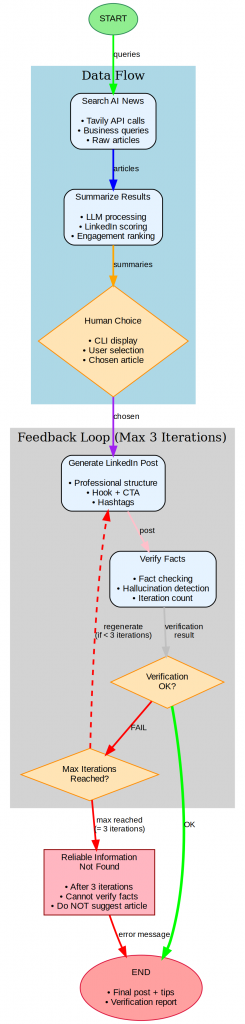

Fase 1: Flujo de datos

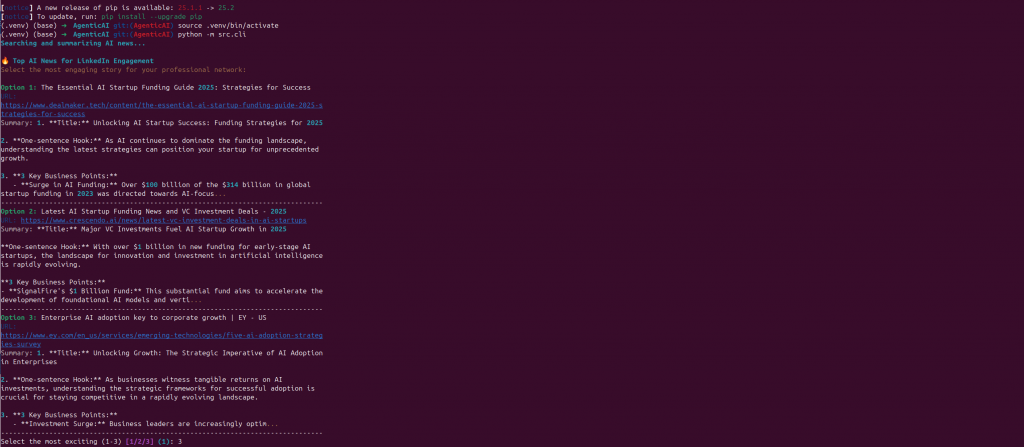

El proceso comienza con el componente Search AI News, donde el sistema consulta la API de Tavily utilizando una serie de consultas predefinidas orientadas al ámbito empresarial, como “AI startup funding” o “AI job market trends”. Este paso recupera artículos relevantes sobre la actividad reciente en investigación y en la industria de la IA.

A continuación, el módulo Summarise Results procesa estos artículos mediante un modelo de lenguaje para extraer los aspectos más relevantes y generar resúmenes adaptados a publicaciones de LinkedIn. Cada resumen se evalúa según criterios de pertinencia profesional y potencial de interacción, priorizando la información más útil y susceptible de generar debate.

Finalmente, el paso Human Choice incorpora un componente de supervisión humana. El sistema muestra en la interfaz de línea de comandos los resúmenes mejor valorados, permitiendo al usuario seleccionar el artículo más adecuado para su publicación. Este diseño garantiza revisión editorial sin comprometer la eficiencia del flujo automatizado.

Fase 2: Bucle de retroalimentación (máximo 3 iteraciones)

Tras la selección del artículo, el flujo pasa al bucle de retroalimentación, donde se generan, verifican y refinan las versiones del texto final destinado a LinkedIn.

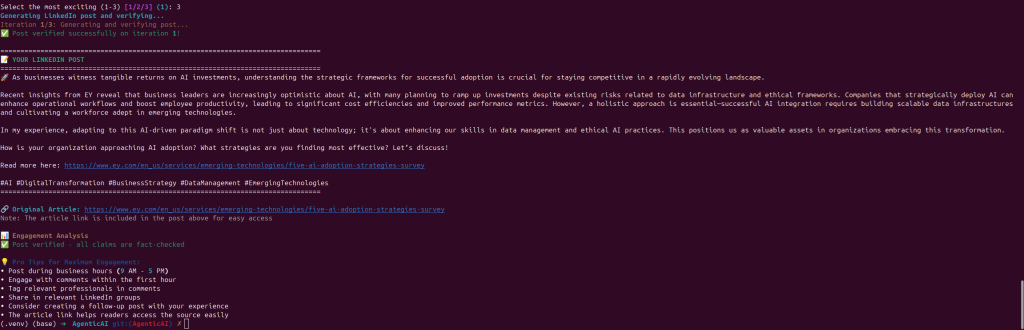

El módulo Generate LinkedIn Post estructura el contenido siguiendo las buenas prácticas de redacción para la plataforma: incluye un inicio claro, una idea principal concisa y una llamada a la acción efectiva. Posteriormente, el componente Verify Facts contrasta todas las afirmaciones con la fuente original para detectar posibles inexactitudes o errores.

Si la verificación no se supera, el sistema ejecuta automáticamente una nueva iteración, incorporando la retroalimentación para corregir las inconsistencias detectadas. Este proceso puede repetirse hasta un máximo de tres veces, mejorando progresivamente el resultado.

Si después de tres intentos no se logra confirmar información fiable, el proceso finaliza con el estado “Información no verificada”, evitando así la publicación de contenido no contrastado. En caso contrario, cuando la verificación se completa con éxito, el sistema genera el resultado final: una publicación validada para LinkedIn acompañada de un informe de verificación que garantiza la transparencia del proceso.

Cada uno de estos componentes opera sobre una memoria y un estado compartidos, gestionados por el motor de flujos de LangGraph. En conjunto, el sistema constituye un ejemplo práctico de Agentic AI: un entorno capaz de ejecutar los pasos definidos por el desarrollador para asegurar que el flujo de trabajo produzca los resultados esperados.

Antes de analizar el marco técnico, conviene destacar por qué este bucle de retroalimentación resulta fundamental para la fiabilidad del sistema.

El núcleo de Agentic AI: el bucle de verificación y retroalimentación

La innovación más destacada del LinkedIn News Agent, y el ejemplo más claro de las capacidades de Agentic AI, es el bucle de verificación y retroalimentación. Este mecanismo permite al sistema detectar discrepancias, aplicar procedimientos de corrección y ajustar los resultados mediante iteraciones estructuradas.

Descripción del proceso

- Generación inicial: el sistema produce una publicación para LinkedIn utilizando el artículo seleccionado como entrada, generando un texto estructurado que resalta los aspectos más relevantes y la información contextual (Figura 2).

- Verificación de hechos: un módulo de verificación compara cada afirmación del borrador con el material de origen. Las declaraciones no verificadas o inconsistentes se registran y clasifican para su corrección (Figura 3).

- Punto de decisión: el flujo de trabajo evalúa los resultados de la verificación según umbrales de calidad y precisión previamente definidos, determinando si es necesario continuar con el procesamiento.

- Regeneración: si la verificación no supera los criterios establecidos, el sistema repite el proceso de generación incorporando los datos de retroalimentación para ajustar el contenido.

- Límite de iteración: tras un máximo de tres ciclos de verificación y regeneración, el sistema genera una publicación verificada o un informe diagnóstico que resume los problemas no resueltos (Figura 4).

Este bucle iterativo de corrección representa una transición de la generación estática de texto hacia una computación con estado y guiada por retroalimentación. En lugar de producir un único resultado, el flujo de trabajo utiliza los datos de verificación para controlar de forma dinámica las rutas de ejecución hasta alcanzar una condición de estabilidad o un criterio de finalización.

En términos operativos, este diseño mejora la fiabilidad y la trazabilidad: cada salida se fundamenta en datos verificables y cada paso del proceso queda registrado y puede auditarse. El resultado no es simplemente la creación automatizada de contenido, sino un sistema reproducible y transparente para generar información validada con controles de calidad medibles.

La Figura 2 muestra una ventana de terminal con la ejecución del proyecto LinkedIn News Agent. El programa busca y resume noticias recientes relacionadas con la inteligencia artificial, presentando tres opciones de artículos optimizadas para el formato de LinkedIn. Cada opción incluye el título del artículo, su URL, una frase introductoria y tres puntos clave de interés empresarial. Al finalizar, el sistema solicita al usuario seleccionar el artículo más relevante para continuar con el procesamiento, introduciendo un número entre 1 y 3.

La Figura 3 muestra la salida de la interfaz de línea de comandos del LinkedIn News Agent tras generar y verificar una posible publicación para LinkedIn. En este ejemplo, el sistema completa con éxito la primera iteración de verificación y muestra la publicación formateada, incluyendo el texto principal, el enlace al artículo, los hashtags y las recomendaciones de interacción. El análisis de verificación y relevancia confirma que todas las afirmaciones de la publicación han sido contrastadas con las fuentes originales.

El LinkedIn News Agent demuestra de forma práctica las capacidades de un sistema de Agentic AI, al completar de manera automatizada un flujo completo de generación de contenido —desde la obtención de información hasta la publicación verificada—. Como se observa en la Figura 4, el sistema genera una publicación final depurada y contrastada, que incluye una introducción breve, ideas estructuradas y hashtags relevantes, todo ello derivado de fuentes verificadas. El resultado mantiene un tono profesional y una secuencia lógica coherente, mostrando la integración efectiva de los módulos de búsqueda, resumen, verificación y composición dentro de un flujo coordinado. Este resultado pone de relieve no solo la capacidad del sistema para realizar automatizaciones fiables, sino también el potencial de las arquitecturas Agentic AI para fomentar una difusión de información transparente y de alta calidad en entornos profesionales.

LangGraph: la base técnica

El LinkedIn News Agent está construido sobre LangGraph, un framework que amplía el concepto de prompt chaining introducido por LangChain. LangGraph permite crear flujos de trabajo completos y con estado, en los que múltiples componentes —como la recuperación de información, la síntesis, la verificación y la generación de texto— operan dentro de un proceso coordinado.

Como capa de orquestación, LangGraph gestiona el orden de ejecución, el intercambio de datos y las bifurcaciones condicionales. El flujo de trabajo se define mediante una función build_workflow que establece la secuencia de cada etapa: obtener noticias sobre IA → resumir los elementos clave → pausar para la selección humana → generar y verificar la publicación de LinkedIn. El paso de supervisión humana garantiza una revisión editorial dentro de un proceso automatizado.

Una de las principales fortalezas de LangGraph es su capacidad para preservar el estado y el contexto entre ejecuciones. En lugar de reiniciarse en cada instrucción, mantiene consultas, resúmenes, resultados de verificación y recuentos de iteraciones, asegurando así la continuidad y la reproducibilidad. El enrutamiento condicional permite que el proceso siga diferentes rutas según los resultados de la verificación, codificados como reglas explícitas dentro del grafo del flujo de trabajo.

En resumen, LangGraph proporciona la infraestructura necesaria para construir flujos de trabajo de IA deterministas, auditables y guiados por retroalimentación, transformando los modelos de lenguaje de gran tamaño en componentes fiables dentro de sistemas computacionales controlados.

Conclusión

Agentic AI marca un cambio metodológico: del texto generado sin estado a una computación estructurada con control de retroalimentación. Al integrar memoria, lógica condicional y ciclos de verificación, frameworks como LangGraph demuestran cómo los flujos de trabajo multinivel pueden operar con coherencia, trazabilidad y reproducibilidad.

A diferencia de los modelos generativos convencionales, la implementación de agentes de IA permite conservar el contexto entre operaciones, evalúar los resultados intermedios y ajustar los pasos siguientes según criterios definidos, permitiendo de ese modo un comportamiento determinista y un control de calidad explícito.

En última instancia, Agentic AI no constituye un sistema completamente autónomo, sino un paradigma computacional que ofrece al desarrollador la posibilidad de incorporar el control, la verificación y la preservación del contexto. Su potencial no reside en modelos cada vez más grandes, sino en arquitecturas que hagan la inteligencia artificial transparente, fiable y auditable en entornos de investigación y empresariales.

La evolución de la inteligencia artificial no depende de modelos cada vez más grandes, sino de arquitecturas capaces de conservar el estado, verificar los resultados y realizar iteraciones con precisión.