Parte I – El espejismo del progreso infinito

La inteligencia artificial se ha convertido en una presencia cotidiana. Los nombres de sus modelos —GPT-3, GPT-4, GPT-5, Gemini, DeepSeek— aparecen cada vez con más frecuencia en los medios, asociados a logros que hace unos años habríamos considerado ciencia ficción: traducir idiomas en segundos, escribir historias coherentes, resolver problemas matemáticos o generar imágenes que parecen sacadas de la imaginación de un artista humano.

Pero con cada avance aparece una pregunta incómoda:

¿tiene la IA un límite en su desarrollo, o seguirá creciendo indefinidamente?

La metáfora de la asíntota

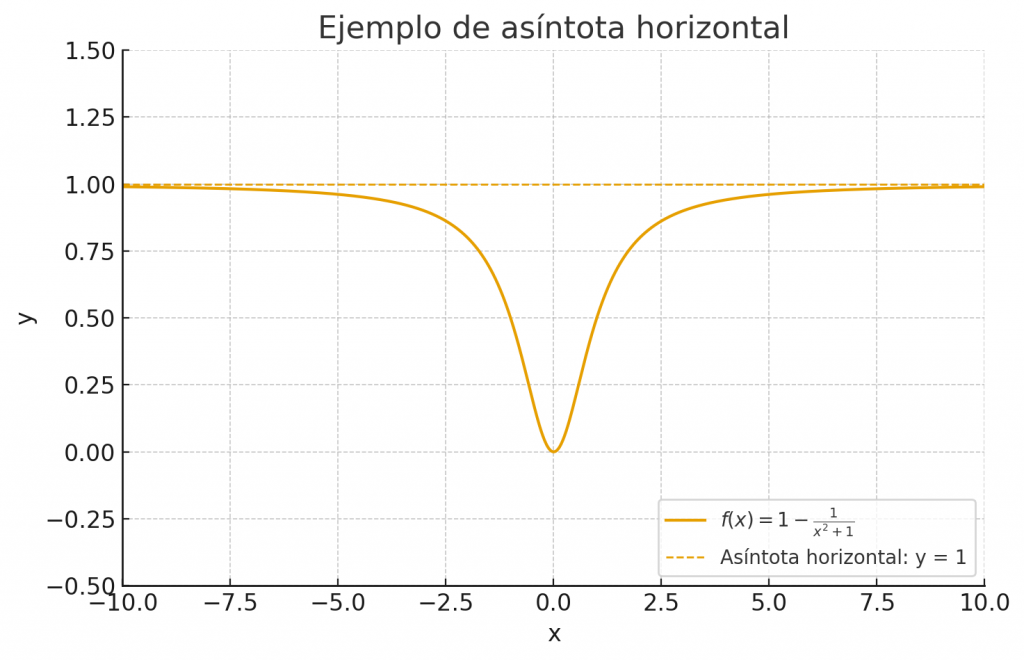

En matemáticas, una asíntota es una línea a la que una función se acerca pero nunca llega a tocar. Como ejemplo, veamos el comportamiento de la siguiente función:

![]()

En la gráfica inferior, podemos ver que la función ![]() tiene una asíntota horizontal en

tiene una asíntota horizontal en ![]() .

.

En la práctica, significa que la función tiene un límite superior que no puede ser superado. Ésta analogía se usa mucho para explicar el progreso de la Inteligencia Artificial. El salto de GPT-3 a GPT-4 fue enorme: pasamos de un sistema sorprendente pero plagado de errores a uno capaz de generar resultados de forma mucho más consistente. Sin embargo, el paso de GPT-4 a GPT-5 no se sintió igual de revolucionario. Sí, GPT-5 es más preciso, tiene menos fallos y maneja contextos mucho más grandes, pero ya no hay una sensación de “antes y después” como ocurrió con generaciones anteriores.

Es como subir una colina empinada: los primeros metros nos hacen ganar mucha altura, pero cada paso adicional nos cuesta más y aporta menos.

La naturaleza determinista de la IA

Parte de la explicación está en la propia naturaleza de estos sistemas. Por mucho que nos deslumbren, los algoritmos que hoy dominan el panorama son deterministas: dadas unas condiciones iniciales, producen siempre la misma salida (o la misma distribución de probabilidades).

Eso los hace consistentes y fiables, pero también les impide algo fundamental: no tienen conciencia, ni intencionalidad, ni experiencia subjetiva. Procesan datos, no “entienden” en el sentido humano de la palabra.

Lo que llamamos “inteligencia artificial” es, en realidad, una inteligencia instrumental: está diseñada para resolver problemas de forma eficaz, no para experimentar el mundo.

¿Qué es inteligencia, en realidad?

Aquí encontramos la clave de la discusión.

- Si definimos la inteligencia como la capacidad de resolver problemas, entonces la IA puede crecer indefinidamente. Siempre habrá una nueva técnica o un nuevo paradigma que supere a los anteriores.

- Pero si creemos que la inteligencia requiere conciencia, entendida como experiencia subjetiva, emociones y autopercepción, entonces los algoritmos actuales están atrapados en un límite global. Podrán ser cada vez mejores solucionadores de problemas, pero nunca serán inteligentes en el mismo sentido que nosotros debido a su naturaleza determinística.

Algoritmos perfectos… pero inadecuados

Un aspecto curioso es que podemos entrenar algoritmos casi perfectos para una tarea concreta y, al mismo tiempo, inútiles en otra.

- Un traductor automático puede lograr una precisión altísima al pasar textos del inglés al español, pero no sabrá jugar al ajedrez.

- Un algoritmo de ajedrez puede derrotar al campeón mundial, pero no entenderá un poema.

Esto no es un fallo, sino una consecuencia natural: no existen algoritmos universales que sean óptimos para todas las tareas. Lo que funciona de forma brillante en un dominio puede ser totalmente inadecuado en otro.

¿Un muro o una escalera?

Llegados a este punto, cabe preguntarse: ¿existe un muro que detenga el desarrollo de la IA?

La respuesta parece ser no. La IA no avanza hacia un límite infranqueable, sino como quien sube una escalera: cada peldaño representa un paradigma. Al principio del peldaño, los avances son rápidos y espectaculares; después, las mejoras se hacen más pequeñas y costosas, hasta que la curva se aplana. Entonces, alguien inventa un nuevo enfoque y aparece un nuevo peldaño más arriba.

Parte II – Entre Bayes, P vs NP y el No Free Lunch

En la primera parte de esta serie vimos que la inteligencia artificial progresa como quien sube una escalera de peldaños asintóticos: cada paradigma se aplanaba hasta que aparecía uno nuevo que abría otro tramo. Pero para comprender mejor cuáles son los límites reales de la IA, conviene detenernos en algunas ideas fundamentales de la teoría de la computación y del aprendizaje automático.

El error de Bayes: el límite estadístico

Imagina que intentas diagnosticar una enfermedad únicamente a partir de síntomas visibles. Puede que dos enfermedades distintas provoquen exactamente los mismos signos: fiebre, tos y cansancio. Si no tienes más información —un análisis de sangre, por ejemplo— no importa lo bueno que sea tu médico o tu algoritmo: hay un nivel de error que no se puede eliminar.

Ese límite es lo que en estadística se llama error de Bayes. Es el error mínimo posible de cualquier clasificador, incluso del mejor imaginable, porque está determinado por la propia información disponible en los datos.

En términos técnicos, se define como el riesgo esperado mínimo: la probabilidad de equivocarse cuando se usa la mejor regla de decisión posible para una distribución de datos concreta.

Dicho de otro modo: la IA puede acercarse a ese límite, pero nunca lo superará.

P y NP: problemas fáciles de resolver… y problemas fáciles de verificar

Otro límite aparece cuando nos fijamos en la naturaleza de los problemas que intentamos resolver.

- La clase P agrupa aquellos problemas que pueden resolverse de manera eficiente, es decir, en un tiempo que crece como un polinomio del tamaño de la entrada. Por ejemplo, ordenar una lista de números está en P: incluso si la lista tiene millones de elementos, podemos hacerlo con algoritmos muy rápidos.

- La clase NP representa problemas cuya solución es fácil de verificar, aunque encontrarla pueda ser extraordinariamente costoso. Un ejemplo clásico es el problema del viajante: recorrer un conjunto de ciudades pasando por todas ellas una vez y con el menor coste posible. Si alguien nos da un recorrido, comprobar que cumple las condiciones es rápido; pero encontrarlo desde cero puede ser prohibitivo.

La gran incógnita es si P = NP.

- Si fueran iguales, todo problema cuya solución se pueda verificar también podría resolverse rápidamente.

- Si son distintos (lo que la mayoría de expertos cree), entonces existen problemas que ni la IA más avanzada podrá resolver de manera eficiente.

Es decir: aunque podamos entrenar algoritmos cada vez más potentes, hay problemas que siguen siendo intratables en su propia naturaleza.

El teorema No Free Lunch: no hay almuerzo gratis

Supongamos que tienes un martillo perfecto. Podrás clavar clavos de forma impecable, pero no servirá para cortar madera o apretar tornillos.

Ese es, en esencia, el mensaje del teorema del No Free Lunch (NFL). Demuestra que, en promedio sobre todos los problemas posibles, ningún algoritmo es mejor que otro.

Lo que explica por qué podemos tener un algoritmo casi perfecto en un dominio (por ejemplo, traducir entre inglés y español), y al mismo tiempo inútil en otro (resolver ecuaciones diferenciales). Cada tarea requiere un sesgo inductivo distinto, un tipo de “herramienta” adaptada a la estructura del problema.

Los límites físicos

Finalmente, aunque superáramos los límites estadísticos y algorítmicos, quedaría el mundo real:

- El principio de Landauer establece que borrar un solo bit de información consume una energía mínima, lo que marca un límite termodinámico para la computación.

- La velocidad de la luz limita el tiempo de comunicación en supercomputadores distribuidos.

- Y el coste económico de entrenar modelos gigantes crece de manera casi exponencial.

En otras palabras: incluso la IA más prometedora está sujeta a las mismas leyes de la física que nosotros.

¿Límite local o límite global?

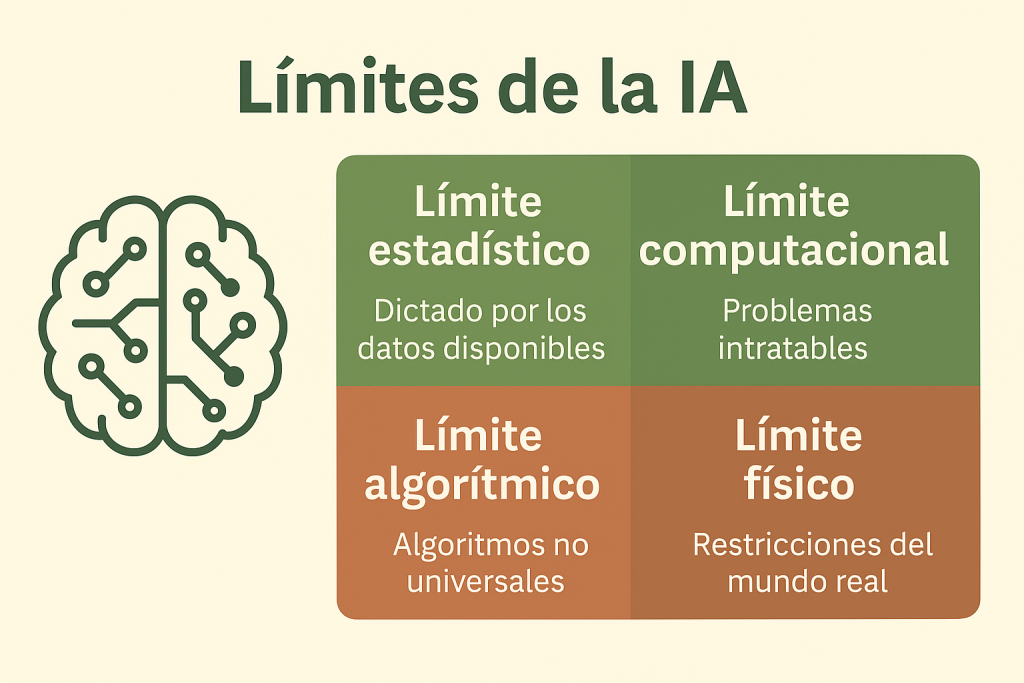

Todos estos factores apuntan a que la IA tiene límites claros, pero no absolutos:

- Son límites locales, que dependen del paradigma, de los datos y de los recursos disponibles.

- Pero si definimos inteligencia como inseparable de la conciencia, entonces sí: la IA actual, determinista y carente de subjetividad, se enfrenta a una asíntota global que no podrá cruzar.

Conclusión

La IA no avanza hacia un muro único e infranqueable, sino dentro de un paisaje lleno de fronteras móviles: el error de Bayes marca lo que pueden lograr los datos, P vs NP define lo que es computacionalmente accesible y el teorema del No Free Lunch nos recuerda que no hay algoritmos universales.

El desarrollo futuro de la IA dependerá de cómo interpretemos estas fronteras:

- ¿Como un recordatorio de que solo existe la inteligencia instrumental, cada vez más poderosa pero limitada?

- ¿O como un estímulo para replantear qué entendemos por inteligencia y si la conciencia es un requisito imprescindible?

“No podemos detener el futuro, pero sí prepararnos para él.”

— Hari Seldon, Fundación