Como indiqué hace ya unas semanas en la entrada «Anatomía de un algoritmo de IA», mi intención es generar un contenido claro que permita al lector entender un poco mejor los procesos que tienen lugar, detrás de las bambalinas, cada vez que preguntamos algo a un modelo de lenguaje extenso (LLM por sus siglas en inglés). Después de describir la anatomía de un algoritmo de IA, el objetivo de ésta entrada es explicar como funcionan las unidades principales que componen las redes neuronales. Para ello veremos el funcionamiento de las neuronas artificiales así como el del perceptrón que son los pilares fundamentales sobre los que se construyen las redes neuronales.

Como siempre, he contado con la ayuda inestimable de mi colega R. D. Olivaw, el cuál se ha se ha encargado de recopilar parte del contenido incluido en ésta entrada.

Nota: El código usado para generar los datos incluidos en ésta entrada lo encontrarás en el siguiente repositorio.

¿Por qué son importantes?

Las neuronas artificiales y los perceptrones son los bloques de construcción de las redes neuronales, que hoy en día se usan en aplicaciones como el reconocimiento de voz, los coches autónomos y los sistemas de recomendación. Aunque el perceptrón tiene limitaciones (por ejemplo, no puede resolver problemas complejos como el reconocimiento de rostros por sí solo), fue el primer paso hacia el desarrollo de sistemas de inteligencia artificial más avanzados.

¿Qué es una neurona artificial? – explicación divulgativa

Las neuronas artificiales fueron presentadas por primera vez en 1943 por Warren McCulloch y Walter Pitts en su artículo «A Logical Calculus of the Ideas Immanent in Nervous Activity« (McCulloch & Pitts, 1943). En este trabajo, propusieron un modelo matemático inspirado en las neuronas biológicas, conocido como neurona de McCulloch-Pitts, que sirvió como base para el desarrollo de las redes neuronales artificiales y la inteligencia artificial.

Imagina que estás tratando de enseñarle a una computadora a reconocer imágenes de gatos. ¿Cómo lo harías? Una forma es inspirarse en el cerebro humano, que está compuesto por billones de neuronas que se comunican entre sí para procesar información. Una neurona artificial es una versión simplificada de una neurona biológica, diseñada para imitar su comportamiento básico.

En esencia, una neurona artificial toma varias entradas (como los píxeles de una imagen), las combina de cierta manera y decide si «se activa» o no. Si se activa, envía una señal; si no, permanece en silencio. La neurona artificial se diseñó así porque es una forma muy simplificada de como entendemos que funcionan las neuronas en nuestros cerebros cuando deciden si transmitir un impulso eléctrico.

¿Qué es un perceptrón? – explicación divulgativa

El perceptrón es el modelo más simple de una neurona artificial pero con una peculiaridad importantísima. Fue creado en 1957 por Frank Rosenblatt y es la base de las redes neuronales modernas. Piensa en él como una «caja de decisiones» que clasifica cosas en dos categorías. Es decir, incluye un paso destinado al ajuste de parámetros que le permite distinguir entre fotos de gatos y perros.

El perceptrón funciona así:

- Recibe varias entradas (como características de una imagen).

- Les asigna un «peso» a cada una (algunas características son más importantes que otras).

- Suma todas las entradas ponderadas.

- Decide si la suma supera un umbral. Si lo hace, dice «sí» (salida 1); si no, dice «no» (salida 0).

Aunque es simple, el perceptrón es poderoso porque introdujo el primer modelo de ajuste de parámetros automáticos basado en la minimización de error de clasificación. Si comete un error, ajusta sus pesos para mejorar la próxima vez.

¿Cómo funciona una neurona artificial? – No es magia son matemáticas

¡Aventurer@ de los números! Nos vamos a adentrar en un territorio donde las matemáticas puede que se compliquen. Pero no entres en pánico, no necesitas un doctorado, solo algo de curiosidad, valentía y, si es necesario, una taza de café bien fuerte. ¡Allá vamos!

Vamos a implementar un perceptrón en Python para clasificar 100 puntos aleatorios en un plano 2D. Supongamos que tenemos dos clases de puntos: clase 0 (puntos rojos) y clase 1 (puntos azules). Queremos que el perceptrón trace una línea que separe las dos clases. Primero que nada, procedemos a crear los datos de forma sintética, para eso usamos:

# Generar 100 puntos aleatorios con etiquetas X = np.random.rand(100, 2) * 10 # Puntos en el rango [0, 10] etiquetas = (X[:, 0] + X[:, 1] >= 10).astype(int)

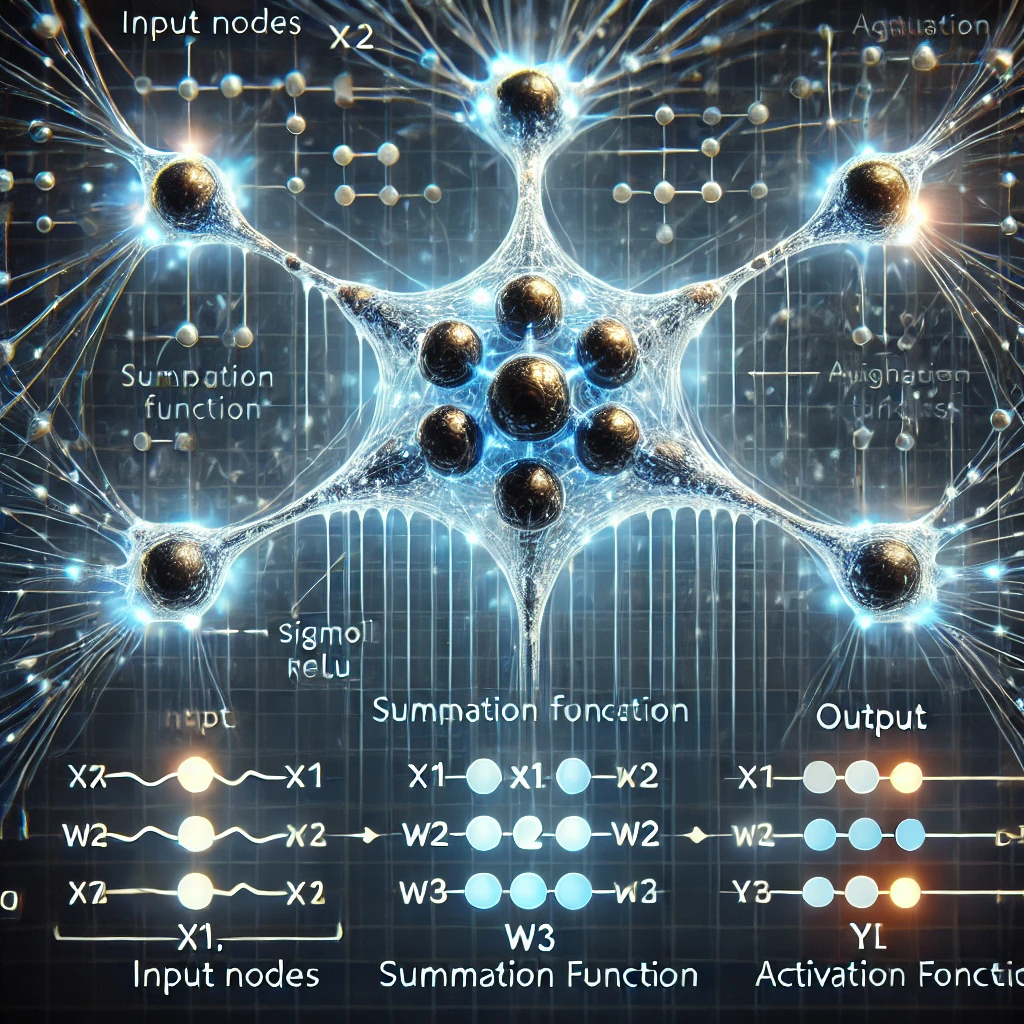

Modelo matemático de una neurona artificial

Una neurona artificial toma ![]() entradas (

entradas (![]() ,

,![]() ,…,

,…,![]() ), cada una con un peso asociado (

), cada una con un peso asociado (![]() ,

, ![]() ,…,

,…,![]() ). Además, tiene un término de sesgo (

). Además, tiene un término de sesgo (![]() ). La salida (

). La salida (![]() ) se calcula como:

) se calcula como:

![]()

Esto se puede expresar en forma vectorial como:

![]()

Donde

![]()

En el caso del perceptrón, la función de activación es la función escalón:

![Rendered by QuickLaTeX.com \[f(z) = \begin{cases}1 & \text{si } z \geq 0 \\0 & \text{si } z < 0\end{cases}\]](https://ideas-artificiales.es/wp-content/ql-cache/quicklatex.com-3dc896002631fa90565c62872a924ad9_l3.png)

Ajuste de parámetros del perceptrón

El factor diferencial del perceptrón, desarrollado por Frank Rosenblatt en 1958, es que fue el primer modelo de neurona artificial que podía ajustar sus parámetros automáticamente a través de la minimización de error. Dicho de otra forma, introdujo un algoritmo de ajuste de parámetros supervisado, que ajustaba los pesos de manera iterativa para reducir errores en la clasificación de datos.

1. Inicialización:

Los pesos ![]() ,

, ![]() ,…,

,…,![]() y el sesgo

y el sesgo ![]() se inicializan con valores pequeños, aleatorios, o ceros. En el código:

se inicializan con valores pequeños, aleatorios, o ceros. En el código:

w = np.random.rand(2) # Pesos para x1 y x2 b = np.random.rand() # Sesgo

2. Cálculo de la salida:

Para cada ejemplo de entrenamiento, se calcula la salida ![]() utilizando la suma ponderada y la función de activación.

utilizando la suma ponderada y la función de activación.

3. Actualización de pesos:

Si la salida ![]() no coincide con la etiqueta verdadera

no coincide con la etiqueta verdadera ![]() , se actualizan los pesos y el sesgo utilizando la regla de ajuste de parámetros del perceptrón:

, se actualizan los pesos y el sesgo utilizando la regla de ajuste de parámetros del perceptrón:

![]()

Donde:

es la tasa de ajuste de parámetros.

es la tasa de ajuste de parámetros. es la etiqueta verdadera (0 ó 1).

es la etiqueta verdadera (0 ó 1). es la salida del perceptrón.

es la salida del perceptrón. es la entrada correspondiente.

es la entrada correspondiente.

4. Iteración:

El proceso se repite para todos los ejemplos de entrenamiento hasta que el perceptrón clasifica correctamente la mayoría de los datos o se alcanza un número máximo de iteraciones. En el código el cálculo de la salida y la actualización de pesos se implementa de forma iterativa como sigue:

for iteracion in range(n_iteraciones):

for i in range(n_puntos):

x1, x2 = X[i] # Entradas

etiqueta = etiquetas[i] # Etiqueta verdadera

# Cálculo de la salida

z = w[0] * x1 + w[1] * x2 + b # Suma ponderada

y = funcion_activacion(z) # Aplicar función de activación

# Actualización de pesos y sesgo

w[0] += tasa_aprendizaje * (etiqueta - y) * x1

w[1] += tasa_aprendizaje * (etiqueta - y) * x2

b += tasa_aprendizaje * (etiqueta - y)

La línea de separación es el conjunto de puntos (![]() ,

, ![]() ) que satisfacen la condición

) que satisfacen la condición ![]() . Es decir, es la frontera entre las dos clases. Matemáticamente, la ecuación de la línea de separación se obtiene igualando z a cero:

. Es decir, es la frontera entre las dos clases. Matemáticamente, la ecuación de la línea de separación se obtiene igualando z a cero:

![]()

Despejando ![]() en términos de

en términos de ![]() , obtenemos la ecuación de la línea en su forma explícita:

, obtenemos la ecuación de la línea en su forma explícita:

![]()

En cada iteración durante la fase de ajuste de parámetros, dibujamos la línea de separación junto con los puntos de datos. La línea se actualiza a medida que los pesos (![]() ,

,![]() ) y el sesgo (

) y el sesgo (![]() ) se ajustan durante la fase de ajuste de parámetros siempre intentando minimizar el error en la clasificación.

) se ajustan durante la fase de ajuste de parámetros siempre intentando minimizar el error en la clasificación.

Limitaciones matemáticas

El perceptrón solo puede clasificar datos linealmente separables. Esto significa que existe un hiperplano (una línea en 2D, un plano en 3D, etc.) que puede separar las dos clases. Si los datos no son linealmente separables (como en el caso de la función XOR), el perceptrón no puede aprender a clasificarlos correctamente.

Neuronas artificiales y su limitación intrínseca

Aunque basado en una analogía simple de un elemento biológico tan complejo del que aún tenemos tantas preguntas que responder como es la neurona, la neurona artificial y su posterior desarrollo ha permitido crear herramientas tan poderosas como ChatGPT o DeepSeek. Es en esa simplificación, aunque pueda parecer una virtud, donde, desde mi punto de vista, subyace la limitación principal de la inteligencia artificial tal y como la conocemos hoy. Roger Penrose ha sido un crítico de la idea de que la conciencia y la inteligencia pueden ser completamente explicadas mediante modelos computacionales basados en neuronas artificiales.

Penrose sostiene que, aunque las redes neuronales artificiales han demostrado ser herramientas poderosas en el aprendizaje automático, estas están basadas en un modelo mecanicista y determinista, mientras que las neuronas biológicas podrían operar a un nivel más profundo, posiblemente a través de la coherencia cuántica en los microtúbulos de las células neuronales (teoría Orch-OR, desarrollada junto con Stuart Hameroff). Según esta hipótesis, los procesos mentales emergen de fenómenos cuánticos dentro de los microtúbulos de las neuronas, lo que haría que el cerebro funcione de una manera fundamentalmente distinta a cualquier sistema basado en computación clásica, incluidas las redes neuronales artificiales.

En este sentido, Penrose critica la idea de que la inteligencia artificial basada en neuronas artificiales pueda alcanzar una verdadera comprensión o consciencia. Según él, los modelos actuales solo imitan patrones de procesamiento de información, pero carecen de las propiedades fundamentales que permiten la experiencia consciente.

Conclusión

Las neuronas artificiales y los perceptrones son la base de las redes neuronales modernas y por tanto de las herramientas de IA que han revolucionado la sociedad durante los últimos años. Aunque han permitido avances significativos en inteligencia artificial, tienen limitaciones, como la incapacidad del perceptrón para clasificar datos no linealmente separables. Si bien estos modelos imitan, de forma simplificada, el procesamiento de información por parte de las neuronas, no está claro si pueden replicar procesos cognitivos más profundos, como la consciencia. Teorías como la de Roger Penrose, premio Nobel de Física en 2020, sugieren que el cerebro humano opera en un nivel distinto al de las redes neuronales artificiales. En definitiva, estas tecnologías han revolucionado la IA, pero aún queda mucho por explorar sobre sus límites y su relación con la inteligencia humana.

«La conciencia humana es algo que no puede explicarse simplemente en términos computacionales. Algo más está ocurriendo en el cerebro que aún no comprendemos» – Roger Penrose